Meta가 현지시간 4월 5일 Llama4 제품군을 발표하였습니다.

허깅페이스에 등록된 시각을 보니 약 3~4시간 전이네요.

요즘 유행하는 추론모델이 아니라 "전례 없는 컨텍스트 길이 지원을 제공하는 최초의 개방형 네이티브 멀티모달 모델이며, MoE 아키텍처를 사용하여 구축된 최초의 모델(We’re introducing Llama 4 Scout and Llama 4 Maverick, the first open-weight natively multimodal models with unprecedented context length support and our first built using a mixture-of-experts (MoE) architecture.)"이라고 소개하고 있습니다.

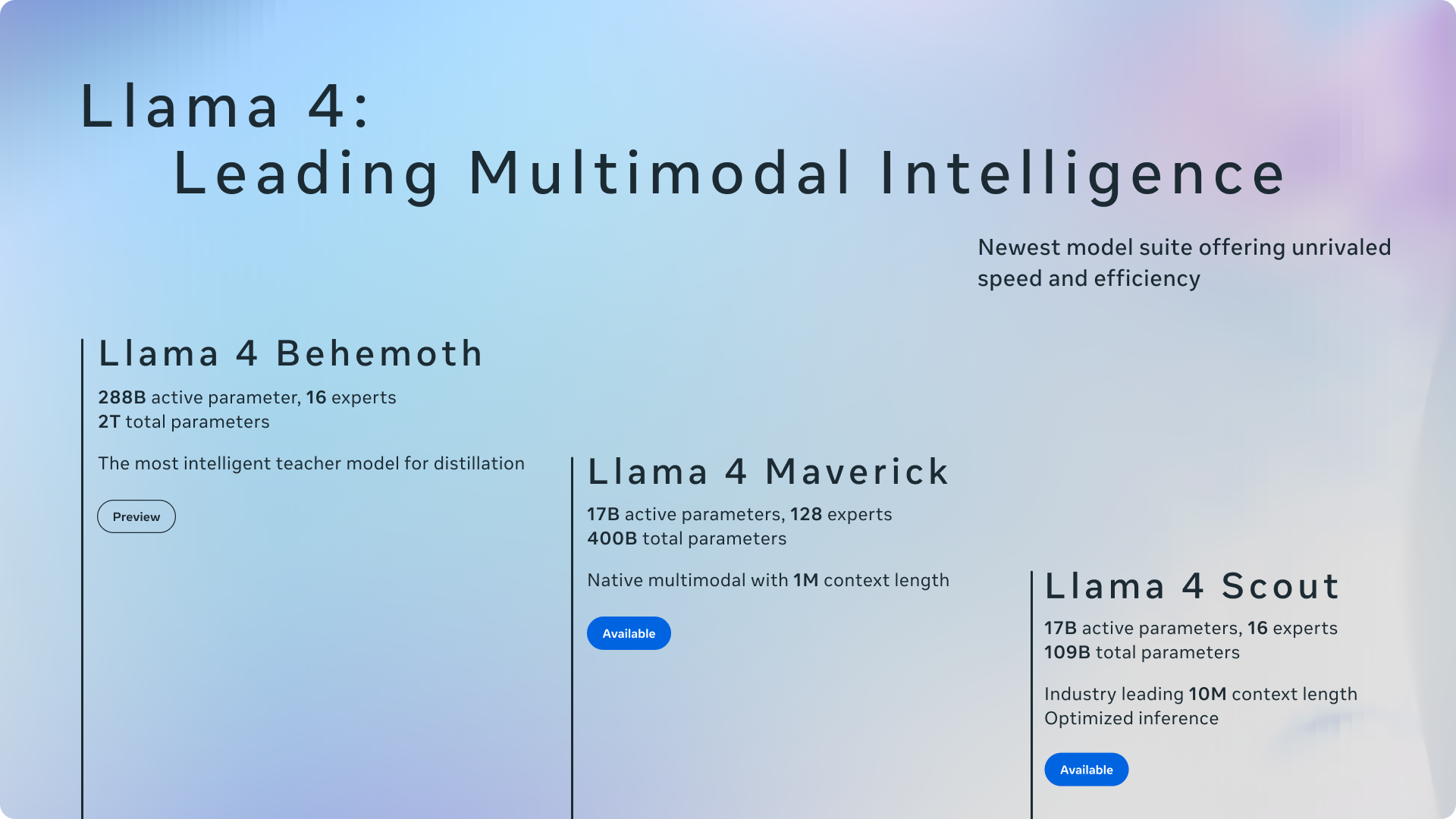

이번에 발표된 Llama4 제품군은 스카우트(Scout), 매버릭(Maverick), 베히모스(Behemoth)의 3종이며 프리뷰를 진행중인 베히모스 외의 2종(스카우트, 매버릭)은 현재, 라마닷컴과 허깅페이스에서 다운로드가 가능합니다.

매버릭과 스카우트 모두 170억(17B)개의 활성 파라미터를 가지고 있으며, 스카우트는 16개의 전문가 모듈과 1090억(190B)개의 파라미터를, 매버릭은 128개의 전문가 모듈과 4000억개의 파라미터를 가지고 있습니다.

스카우트는 컨텍스트 창(Context Window) 의 크기가 1000만(10M) 토큰이라는 어마어마한 크기를 자랑하고 있습니다.

기존 모델 중 최대 토큰 수를 제공했던 구글의 Gemini 1.5 이상 버전이 200만(2M) 토큰의 컨텍스트 창을 제공하고 있었으니 Llama4 스카우트는 그 5배의 크기를 지원하고 있는 것입니다.

매버릭은 100만(1M)개의 네이티브 멀티모달 토큰을 가지고 있습니다.

흔히 말하는 컨텍스트 창(Context Window)는 컨텍스트 길이를 의미하며, 컨텍스트 창은 모델이 한 번에 고려하거나 기억할 수 있는 토큰 단위의 텍스트 양을 의미합니다.

그래서 컨텍스트 창의 크기는 몇 토큰이다.. 라는 식으로 표현합니다.

자연어처리 분야에서 토큰이란 텍스트 데이터를 분석하기 위해 나눈 가장 작은 단위를 의미하며 영어를 기준으로 할 때, 1개의 단어라고 보면 대충 비슷합니다.

Llama4 제품군의 기반은 베히모스이며, 스카우트와 매버릭은 베히모스를 증류(Distillation)한 모델이라고 소개하고 있습니다.

베히모스는 2880억(288B)개의 활성 파라미터를 가지고 있으며 총 파라미터 수는 2조(2T)개에 달합니다.

16개의 전문가 모델로 구성되어 있으며, 지식 증류를 위한 가장 지능적인 교사 모델이라고 소개하고 있습니다.

베히모스는 아직 프리뷰 중이라서 다운로드가 제공되지 않네요.

자세한 설명은 다음 글에서 확인하실 수 있습니다.

https://ai.meta.com/blog/llama-4-multimodal-intelligence/

The Llama 4 herd: The beginning of a new era of natively multimodal AI innovation

Post-training a model with two trillion parameters was a significant challenge too that required us to completely overhaul and revamp the recipe, starting from the scale of data. In order to maximize performance, we had to prune 95% of the SFT data, as opp

ai.meta.com

그리고 사용법에 대한 소개는 Meta의 라마닷컴에서 참고하실 수 있습니다.

https://www.llama.com/docs/model-cards-and-prompt-formats/llama4_omni/

Llama 4 | Model Cards and Prompt formats

Technical details and prompt guidance for Llama 4 Maverick and Llama 4 Scout

www.llama.com

점점 접근하기 어려운 규모가 되어가네요.

그래도 스카우트의 경우, 성능은 지금까지의 모든 세대의 Llama 모델보다 뛰어나지만 NVIDIA H100 GPU 하나로 구동이 가능한 소형모델이라고 합니다.

H100 GPU 하나가 약 4000만원 정도.. 부터 시작하네요.

제가 가지고 있는 것이 NVIDIA RTX 4080인데...

두 모델은 목적이 다른 제품군이라서 비교하기가 어렵지만 H100을 RTX 4080으로 대체하는 것 자체는 가능하다고 합니다.

대신 VRAM의 크기에서 절대적인 차이가 있으므로..

7B 이하의 추론모델까지는 RTX 4080으로 구동, 사용이 가능하지만 그 이상의 모델에서는 메모리 부족 오류가 발생할 것이라고 하네요.

저는 적당히 테스트만 해 보는 선에서 마무리하고.. 7B 이하의 모델을 가지고 연구, 개발을 진행해야 할 것 같네요.

그래도 최신 모델 중 사용 가능한 모델이 있다는 점에 위안을 얻습니다.

'AI & IT' 카테고리의 다른 글

| 네이버, 상업용으로 사용 가능한 HyperCLOVA X-SEED 발표 (4) | 2025.04.24 |

|---|---|

| 오랜만에 사용해 본 ChatGPT (4) | 2025.04.11 |

| 구글 "Gemini Code Assist" 무료 공개 (0) | 2025.02.26 |

| 월드 모델? 물리 AI? LLM은 사라질거라고? 글쎄.. (2) | 2025.02.02 |

| DeepSeek 쇼크 이후 (4) | 2025.02.01 |