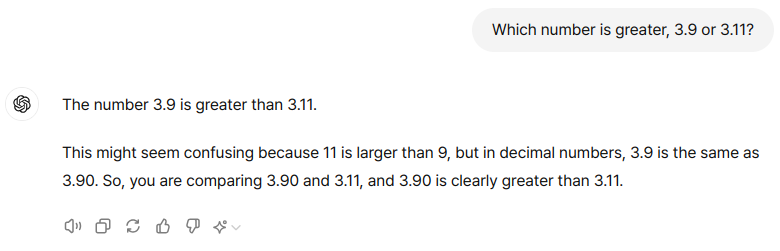

LLM이 가지는 능력의 한계를 확인하기 위해 자주 사용되는 질문이 바로 "3.9와 3.11은 어느것이 더 큰가?"라는 질문입니다.

아마 블로그를 포함해서 많은 글들이 이 주제를 다루고 있을것입니다.

수학적으로 3.9 > 3.11 이 올바른 크기 비교결과라고 할 수 있습니다만..

그런데 LLM에게 질문을 하면 3.11이 더 크다고 설명합니다.

OpenAI의 GPT-3.5-Turbo, MS의 Copilot(GPT-4기반), 네이버의 ClovaX, 구글의 Gemini, Perplexity.ai의 Perplexity에서 질문을 해 보았습니다만.. 모두 틀린 대답을 하더군요.

● GPT-3.5-Turbo의 경우

● Copilot(GPT-4기반)의 경우

● ClovaX의 경우

● Gemini의 경우

● Perplexity의 경우

몇 가지 다른 방법으로 다시 질문을 해도 계속 틀린 대답을 하고 있습니다.

내용을 읽어보면 논리적으로 전혀 맞지 않은 대답입니다.

그리고 중간에 논리의 비약도 일어나고 있는 것을 확인할 수 있네요.

그런데 3.9가 3.11보다 크다는 것이 정답이라고 알려주고 왜 틀린 대답을 했는지 분석해보라고 지시하니까 Gemini와 Perplexity는 자기가 틀린 것을 인정하고 어디가 잘못되었는지 찾아서 다시 설명을 합니다.

● Gemini의 경우

● Perplexity의 경우

그러나 GPT-3.5-Turbo, Copilot(GPT-4기반), ClovaX는 계속 틀린 답을 이야기합니다.

● GPT-3.5-Turbo의 경우

● Copilot(GPT-4기반)의 경우

ClovaX는 말은 자기가 틀렸다고 인정하면서 다시 설명하는 내용은 역시 똑같이 틀린 답을 내놓습니다.

● ClovaX의 경우

그런데 GPT-4 이상의 유료버전을 쓰는 사람의 실험 결과를 보면 영문으로 질문하면 올바른 대답을 하고 한글로 질문하면 틀린 대답을 한다고 하네요.

그래서 GPT-3.5-Turbo에서도 영문으로 질문해 보았습니다.

제대로 대답을 합니다.

나머지 4개의 LLM도 모두 제대로 대답을 하고 있더군요.

솔직히 어이가 없는 것은 ClovaX입니다.

국산 LLM이면서 한글로 질문하면 틀리고 영문으로 질문하면 바르게 대답을 합니다.

이건 좀 문제가 아닐까.. 생각되네요.

(그림: MS Designer Image Creator로 직접 그림)

실제로 여러 도서, 자료 등을 검색하고 읽어보다보면 전세계적으로 기본적인 수학 계산 방법이나 개념을 이상하게 가르치는 나라들이 있습니다.

예를 들면 4칙연산에서는 곱셈과 나눗셈을 먼저 계산하고 덧셈과 뺄셈은 나중에 계산하는 것이 올바른 계산방법인데 일부의 국가에서는 무조건 순서대로 계산하는 것이 옳다고 가르치고 있더군요.

3.9보다 3.11이 크다고 주장하는 것도 그런 데이터가 학습에 영향을 끼친 것이 아닐까합니다.

그러나 영문 데이터에서는 빠르게 수정이 되었지만 한글 데이터에서는 전혀 수정이 이루어지지 않은 것이 문제인듯 합니다.

그리고 GPT-3.5부터 지원된 것으로 알려진 RLHF(Reinforcement Learning Human Feedback, 인간의 피드백을 통한 강화학습) 기능도 한글 대상으로는 제대로 작동하지 않는 것도 원인인듯 합니다.

이미 서비스가 시작된지 2년이 다 되어가고, 그 과정에서 수많은 수정과 보완이 이루어진 LLM이지만 여전히 한글 지원에서는 취약점을 가지고 있고, 아직까지 많은 부분에서 수정되어야 할 부분이 남아있는 것이 LLM을 섣불리 도입하기 어렵게 만들고 있네요.

'AI & IT 이야기' 카테고리의 다른 글

| AGI의 완성을 눈앞에 두고 있다고 주장하는 사람들은..? (20) | 2024.10.07 |

|---|---|

| OpenAI, '스트로베리' 정식 출시, ChatGPT에 'OpenAI o1' 모델 추가 (22) | 2024.09.13 |

| 어떤 오픈소스 LLM을 사용하면 좋을까? (20) | 2024.09.10 |

| 이젠 돈 없으면 LLM은 사용도 못하는 시대가 오고 있나.. (15) | 2024.09.09 |

| 중소 제조 기업의 AI 도입에 대하여... (16) | 2024.09.09 |